1. 简介

深度神经网络的训练是一个复杂的过程,涉及多个需要解决的问题。尽管这些网络具备强大的潜力,但它们的训练过程可能缓慢且容易过拟合。因此,在深度学习研究中,关于如何优化训练过程的探索一直在进行。

批量归一化(Batch Normalization,简称 Batch Norm)就是其中一种被广泛采用的技术。它不仅提升了神经网络的训练速度,还具备一定的正则化效果,有助于防止过拟合。

那么,为什么 Batch Norm 如此重要?它是如何工作的?又该如何将其应用于卷积神经网络(CNN)中?

2. 归一化基础

在深入理解 Batch Norm 的原理和作用之前,先来了解“归一化”这一基础概念。

归一化是一种预处理技术,用于标准化数据。它的核心目标是让不同来源的数据落在相似的范围内。如果不归一化输入数据,可能会导致网络训练困难,甚至显著降低学习效率。

举个例子:假设我们正在构建一个汽车租赁价格预测模型。输入特征包括车辆的使用年限(030年)和行驶里程(0几十万公里)。这两个特征的量纲差异很大,如果不做归一化,模型可能会过度依赖数值范围较大的特征,从而影响预测准确性。

常见的归一化方法有两种:

最小-最大归一化(Min-Max): $$ x_{\text{normalized}} = \frac{x - x_{\min}}{x_{\max} - x_{\min}} $$ 这种方法将数据缩放到 [0,1] 范围,适用于数据分布不均匀但范围明确的场景。

Z-Score 归一化(Standardization): $$ x_{\text{normalized}} = \frac{x - \mu}{\sigma} $$ 其中 $\mu$ 是均值,$\sigma$ 是标准差。这种方法让数据服从标准正态分布,适用于数据分布未知或存在异常值的场景。

在 Batch Norm 中,使用的是第二种方法,即 Z-Score 标准化。

3. 批量归一化(Batch Normalization)

Batch Norm 是一种在网络层之间进行归一化的技术,而不是仅在原始输入数据上进行。它通过在 mini-batch 上对神经元输出进行标准化,从而加速训练过程,并允许使用更高的学习率。

其核心公式如下:

$$ z^N = \left( \frac{z - \mu_z}{\sigma_z} \right) \cdot \gamma + \beta $$

其中:

- $z$ 是神经元输出;

- $\mu_z$ 和 $\sigma_z$ 分别是该 mini-batch 中神经元输出的均值和标准差;

- $\gamma$ 和 $\beta$ 是可学习参数,用于缩放和平移归一化后的输出。

3.1. 应用方式

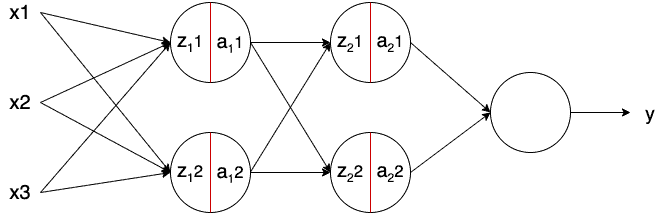

Batch Norm 通常被插入在神经元线性变换($z = w \cdot x + b$)之后、激活函数之前。如下图所示:

一个标准神经元的计算过程为:

$$ z = w \cdot x + b; \quad a = f(z) $$

而加入 Batch Norm 后,变为:

$$ z = w \cdot x; \quad z^N = \left( \frac{z - \mu_z}{\sigma_z} \right) \cdot \gamma + \beta; \quad a = f(z^N) $$

✅ 注意:由于 Batch Norm 已经对输出做了均值偏移($\beta$),因此通常省略了偏置项 $b$。

3.2. Python 实现

在 Keras、TensorFlow 或 PyTorch 等现代深度学习框架中,Batch Norm 的实现非常简单。

以下是一个使用 Keras 构建包含 Batch Norm 的全连接网络示例:

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense, BatchNormalization

model = Sequential([

Dense(16, input_shape=(1, 5), activation='relu'),

BatchNormalization(),

Dense(32, activation='relu'),

BatchNormalization(),

Dense(2, activation='softmax')

])

3.3. Batch Norm 的作用机制

Batch Norm 能够提升训练效率的原因可以从以下几个方面理解:

- 统一输入分布:通过标准化各层输入,使得不同层的输入分布保持一致,从而加快模型收敛。

- 减少内部协变量偏移(Internal Covariate Shift):神经网络中某一层的输入分布随着训练过程不断变化,这种现象称为内部协变量偏移。Batch Norm 通过固定输入的均值和标准差,有效缓解这一问题。

- 正则化效果:由于 Batch Norm 是在 mini-batch 上计算的,因此每次计算的均值和标准差都带有一定的噪声,这在一定程度上起到了类似 Dropout 的正则化作用。

⚠️ 注意:Batch Norm 的正则化效果有限,通常仍需配合 Dropout 使用。

4. 在卷积神经网络中的应用

在 CNN 中,Batch Norm 的应用方式与全连接网络略有不同,但核心思想一致。

卷积层中的特征图(feature map)是通过共享权重的卷积核生成的。因此,Batch Norm 在 CNN 中的归一化是对每个特征图上的所有像素进行统一处理。

也就是说,每个特征图对应一个均值和标准差,而不是像全连接层那样对每个神经元单独计算。

4.1. Python 实现(CNN)

同样地,Keras 提供了开箱即用的 BatchNormalization 层,可以直接用于卷积网络中:

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Conv2D, BatchNormalization, MaxPooling2D, Dense

model = Sequential([

Conv2D(32, (3, 3), input_shape=(28, 28, 3), activation='relu'),

BatchNormalization(),

Conv2D(32, (3, 3), activation='relu'),

BatchNormalization(),

MaxPooling2D(),

Dense(2, activation='softmax')

])

5. 总结

本文介绍了批量归一化(Batch Norm)的基本原理、实现方式及其在卷积神经网络中的应用。通过统一各层输入的分布,Batch Norm 有效提升了训练效率,并具备一定的正则化能力。

✅ 优点总结:

- 加快训练速度;

- 减少内部协变量偏移;

- 提供轻微正则化;

- 支持更大学习率;

- 易于在主流框架中实现。

⚠️ 注意事项:

- Batch Norm 不适用于非常小的 batch size(如小于 16);

- 在推理阶段需使用训练时统计的均值和方差;

- 与 Dropout 配合使用效果更佳。

通过合理使用 Batch Norm,可以显著提升模型的训练效率和泛化能力。