1. 概述

本文将深入探讨神经网络中的隐藏层(Hidden Layers)。我们将先介绍神经网络中不同类型的层结构,然后重点讲解隐藏层的重要性,并通过两个实际案例来加深理解。

对于有经验的开发者来说,神经网络并不陌生。但你是否真正理解隐藏层在其中扮演的角色?它们为什么如此关键?这篇文章将帮你理清思路,避免在模型设计中“踩坑”。

2. 神经网络中的层类型

神经网络一般由三种类型的层构成:

✅ 输入层(Input Layer)

接收原始输入数据,比如图像像素、文本向量等,然后将这些数据传递给下一层。

✅ 隐藏层(Hidden Layer)

这是神经网络的核心部分,位于输入层和输出层之间。隐藏层通过一系列非线性变换来提取数据的特征,使得模型能够学习到复杂的模式。可以有一个或多个隐藏层。

✅ 输出层(Output Layer)

接收隐藏层的输出,进行最终的预测或分类。

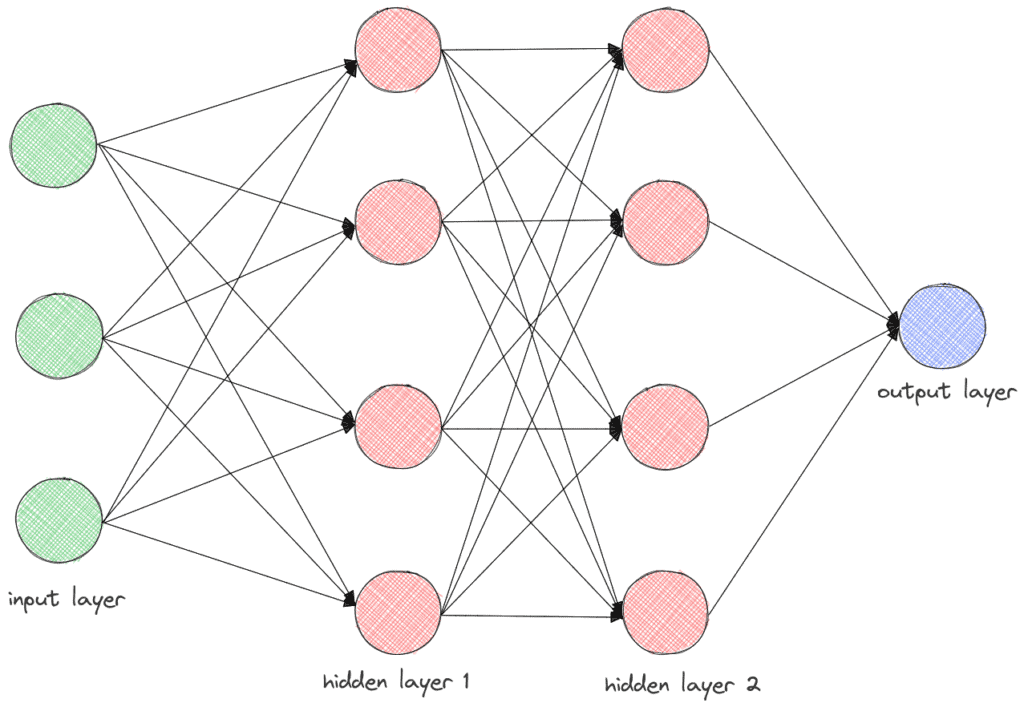

下图展示了一个包含两个隐藏层的前馈神经网络(Feedforward Neural Network)结构:

每个神经元的输出计算方式如下:

$$ y = f \left(\sum_{i=1}^3 x_i \cdot w_i + b\right) $$

其中:

- $ x_i $:输入值

- $ w_i $:权重

- $ b $:偏置项

- $ f() $:激活函数

第一个隐藏层的每个神经元接收输入层的三个输入值进行计算,第二个隐藏层则接收第一个隐藏层的输出作为输入,以此类推。

3. 隐藏层的重要性

隐藏层是神经网络能够处理复杂任务的关键。没有隐藏层的神经网络,其表达能力非常有限。

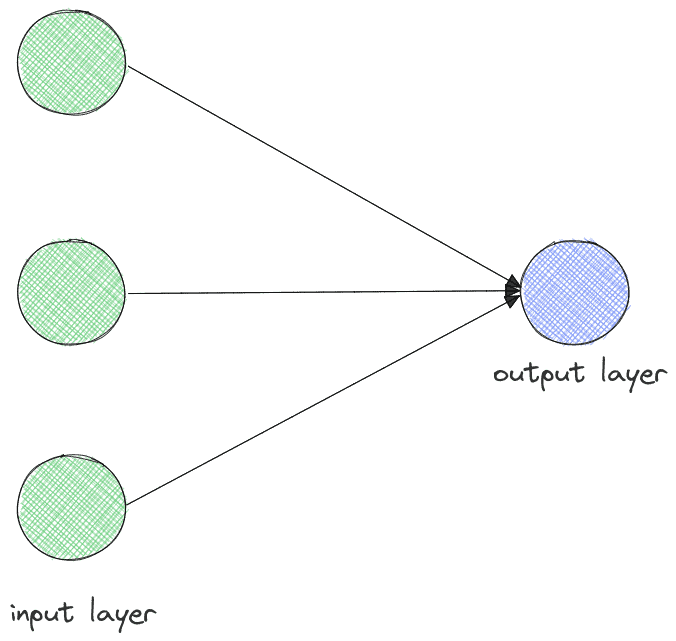

来看一个例子:假设我们有一个没有隐藏层的神经网络,输入为3个特征,输出为1个结果。

此时的输出 $ y $ 实际上是一个线性组合加上一个非线性激活函数的结果。这种结构本质上类似于线性回归模型。

但现实中的很多问题并不是线性可分的。比如图像识别、自然语言理解等任务,线性模型往往表现不佳。这时就需要隐藏层来引入非线性能力,从而提升模型的表达能力。

4. 实例分析

4.1 逻辑函数(XOR)

我们以异或门(XOR)为例,看看隐藏层在非线性分类任务中的作用。

XOR 的真值表如下:

| x₁ | x₂ | 输出 |

|---|---|---|

| 0 | 0 | 0 |

| 0 | 1 | 1 |

| 1 | 0 | 1 |

| 1 | 1 | 0 |

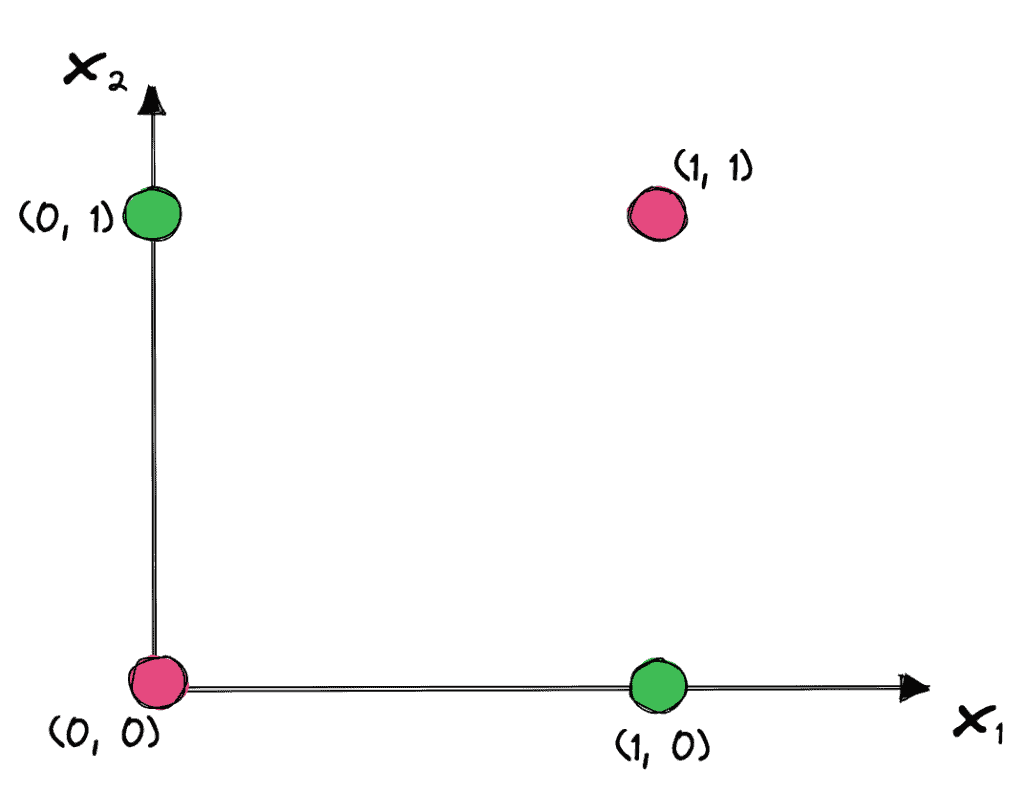

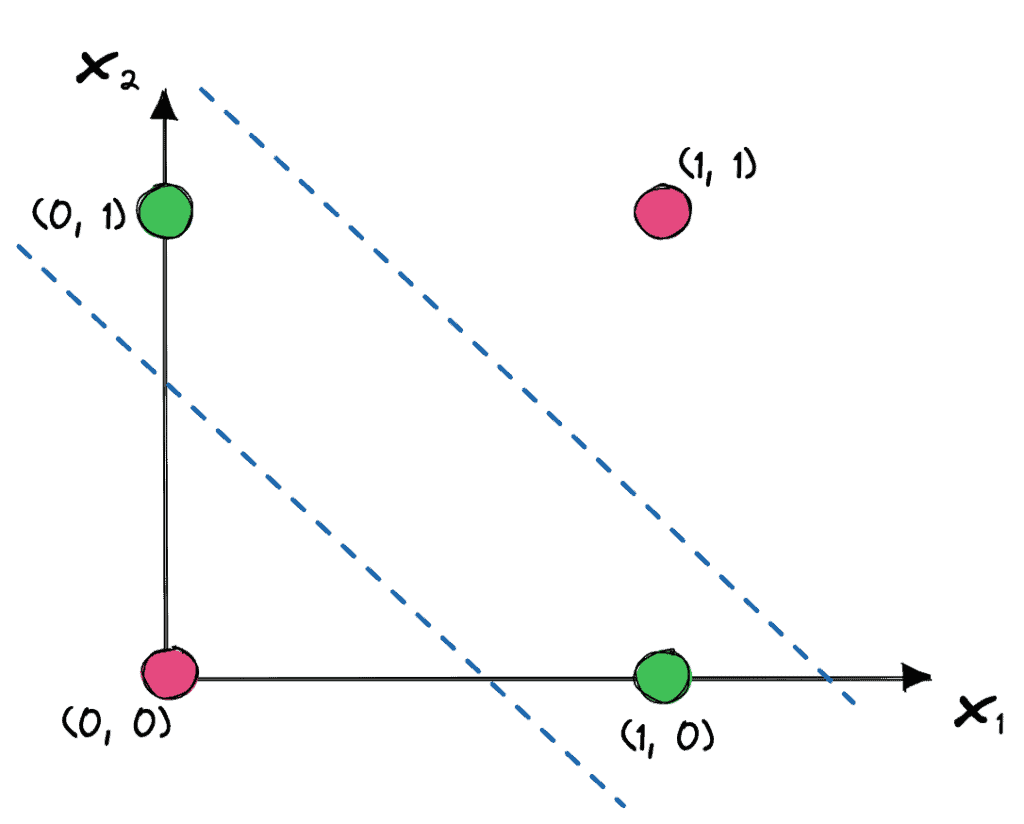

我们可以将这四个点在二维空间中画出来,绿色点表示输出为1,红色点表示输出为0:

如果我们尝试用一个没有隐藏层的神经网络来解决这个问题,会发现它只能用一条直线进行分类,而XOR问题不是线性可分的。

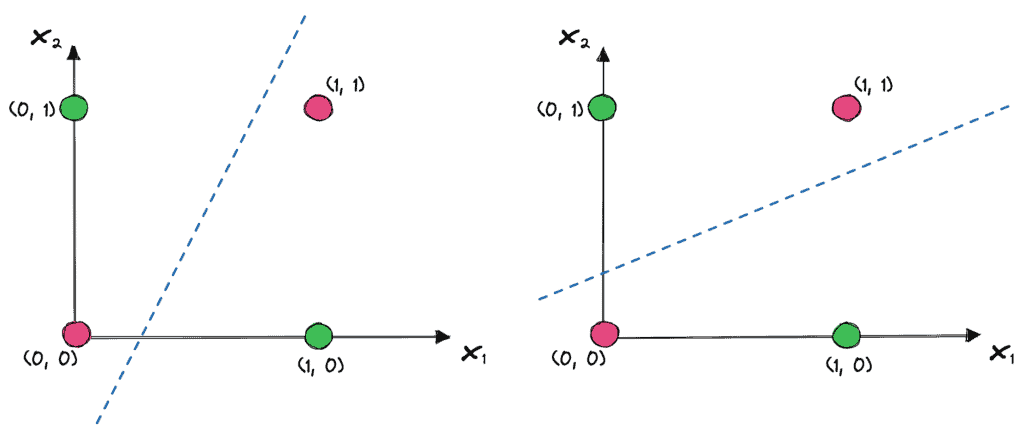

下图展示了线性模型可能学到的几种错误分类线:

解决方案是:在神经网络中加入隐藏层,比如一个包含两个神经元的隐藏层。

这两个神经元各自学习一个线性边界,然后输出层结合它们的输出做出最终判断:

✅ 结论:隐藏层通过非线性变换,将原始输入特征转换为更易于分类的“高级特征”。

4.2 图像识别

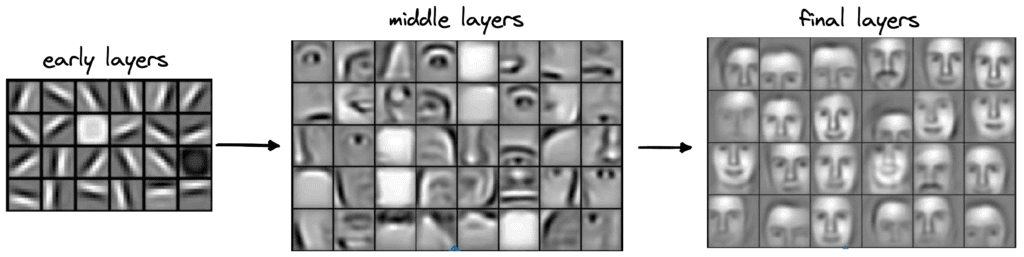

隐藏层的另一个经典应用场景是计算机视觉,尤其是在图像识别任务中。

深度神经网络通过多层隐藏层,逐步从原始像素中提取出越来越抽象的特征:

- 第一层隐藏层:识别图像中的边缘、角点等基础特征

- 中间隐藏层:组合边缘特征,识别眼睛、鼻子、嘴巴等面部局部结构

- 最后几层:进一步组合局部特征,最终识别出整张人脸

下图展示了卷积神经网络(CNN)中每一层的特征提取过程:

✅ 结论:隐藏层通过逐层抽象,使模型能够从像素到语义逐步理解图像内容。

5. 总结

隐藏层是神经网络的核心组成部分,它使得模型能够学习非线性关系,从而胜任图像识别、自然语言处理等复杂任务。

通过两个案例我们也看到:

- 在XOR问题中,隐藏层帮助模型突破线性限制

- 在图像识别中,隐藏层逐层提取特征,实现从像素到语义的转换

作为开发者,在设计神经网络时要合理选择隐藏层的数量和每层的神经元数量。太浅的网络可能无法捕捉复杂模式,太深又可能导致过拟合或训练困难。

📌 建议:根据任务复杂度选择隐藏层数量,从1~2层开始尝试,逐步增加并观察验证集表现。

希望这篇文章能帮助你在构建神经网络模型时,更清楚地理解隐藏层的作用与价值。