1. 简介

信息论(Information Theory)是一门研究信息的数学与统计规律的学科,主要关注信息的传输、存储、检索与变换。它在多个科学与工程领域中都有广泛应用,包括计算机科学、通信工程、量子计算、生物信息学、社会网络分析等。

我们可以将其核心目标理解为:量化信息,并通过数学手段描述其行为与特性。

2. 简要历史

信息论的奠基人是 Claude Shannon(克劳德·香农),他首次提出了信息的量化模型,奠定了现代通信理论的基础。Shannon 在其经典论文《A Mathematical Theory of Communication》中系统地阐述了信息论的基本原理。

除了 Shannon,还有两位先驱也值得提及:

- Harry Nyquist(哈里·奈奎斯特):提出了采样定理,是现代通信系统设计的理论基础之一。

- Ralph Hartley(拉尔夫·哈特利):提出了信息速率与信道频率、传输时间之间的关系,为香农理论提供了早期支撑。

3. 不同语境下的“信息”

“信息”这一概念在不同领域中含义略有不同,以下是两个典型例子:

3.1 计算机科学中的信息

在计算机科学中,信息是经过处理并赋予明确意义的数据。它通常具备以下三个特征(3C):

- ✅ Complete(完整)

- ✅ Correct(准确)

- ✅ Concise(简洁)

信息的价值在于它能帮助我们做出清晰的判断和决策。

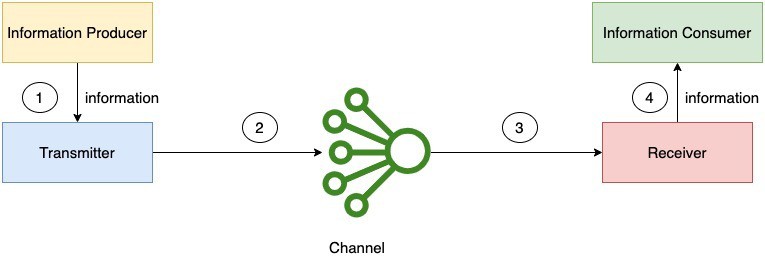

3.2 通信中的信息

在通信系统中,信息是通过媒介在两个实体之间传输的信号。例如:

当你打电话时,你的声音就是信息,它通过空气中的电磁波进行传输。

信息的传输过程包括编码、调制、传输、解调和解码等多个阶段。

4. 信息论的核心思想

信息论的基本观点是:信息可以像质量、能量一样被量化和分析。 信息在系统中可以流动、转换、衰减,类似流体。

通过信息论,我们可以:

- 定义系统中信息传递的上下限

- 评估通信或存储系统的效率

- 描述噪声对信息传输的影响

例如,在一个包含噪声的通信信道中,我们无法无损地传输任意多的信息。此时,信息熵(Entropy) 成为了衡量信息不确定性的关键指标。

4.1 熵(Entropy)

信息熵衡量的是一个随机变量的不确定性。不确定性越高,熵越大。

数学定义如下:

(1)

$$

E(X) = -\sum_{i=1}^n p(x_i) \log_2 p(x_i)

$$

其中:

- $ X $ 是一个离散随机变量

- $ p(x_i) $ 是 $ X = x_i $ 的概率

- 单位是 bit(比特)

✅ 举例说明:

- 如果一个事件发生的概率是 1(即确定事件),熵为 0。

- 如果所有事件等概率发生,熵最大。

5. 信息论的应用

信息论广泛应用于多个领域,如数据压缩、密码学、机器学习、生物信息学等。下面我们介绍两个典型应用场景:

5.1 噪声信道(Noisy Channel)

一个通信信道如果存在噪声,其容量($ C_C $)和熵($ E_C $)之间必须满足:

$$ E_C < C_C $$

只有在这种情况下,我们才能使用编码技术可靠地传输信息。否则,无论采用何种编码方式,都会出现无法纠正的传输错误。

⚠️ 踩坑提示:如果你发现数据在传输过程中频繁出错,可能不是编码的问题,而是信道容量不足,根本无法承载当前的信息量。

5.2 机器学习中的应用

信息论在深度学习中也扮演着重要角色,特别是在损失函数的设计中。

例如,在图像分类任务中,我们常用 交叉熵损失函数(Cross-Entropy Loss) 来训练卷积神经网络(CNN)。

交叉熵定义如下:

(2)

$$

C_{X,Y}(p, q) = -\sum_x p(x) \log_2 q(x)

$$

其中:

- $ p(x) $ 是真实分布

- $ q(x) $ 是模型预测分布

交叉熵衡量的是两个分布之间的差异。值越小,说明模型预测越接近真实情况。

6. 总结

信息论是一门高度数学化的学科,是现代通信、加密、数据压缩和机器学习等技术的核心理论基础。

它帮助我们:

- 量化信息

- 描述信息的不确定性(熵)

- 优化信息传输与处理效率

无论你是在设计通信协议、优化数据压缩算法,还是构建深度学习模型,信息论都能为你提供坚实的理论支撑。