1. 引言

在本教程中,我们将探讨一类受自然界启发的元启发式算法(Metaheuristic Algorithms)。这需要我们理解什么是元启发式算法,以及为什么我们需要它们来解决优化问题。通过这些算法,我们可以更好地理解自然界带来的启发。我们还将详细介绍一些流行的自然启发式算法及其应用场景。

2. 优化问题与元启发式算法

在数学与工程领域,优化问题是指在所有可行解中找出最优解。通常我们将其定义为一个目标函数,可能涉及多个变量,并带有约束条件。这类问题可以是离散的(如整数规划),也可以是连续的(如函数极值问题)。

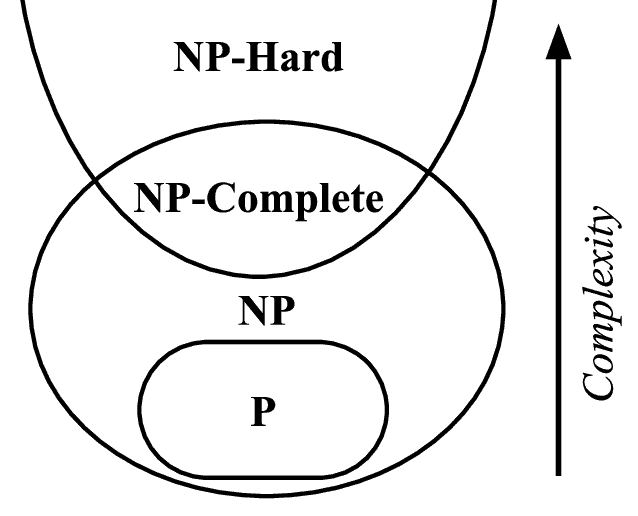

优化问题的复杂性与目标函数和变量数量密切相关。值得注意的是,许多现实世界中的优化问题属于 NP(非确定性多项式时间)问题,这意味着我们无法在合理的时间内找到全局最优解。

关于 NP 或 NP-hard 问题的详细分析超出了本教程的范围,但我们可以理解的是,找到这类问题的全局最优解通常需要大量计算资源,这在实践中往往不可行。例如旅行商问题、图着色问题等都属于此类。

这时,元启发式算法(Metaheuristic)就派上用场了。元启发式是一种高层次的启发式方法,可以为优化问题提供足够好的解。它们通常通过采样部分解空间来工作,而不是穷举所有可能的解。更重要的是,它们可以在信息不完整或不准确的情况下运行。

与数值优化算法不同,元启发式算法不能保证找到全局最优解,但它们可以用更少的计算资源快速找到合理的近似解。许多元启发式算法还采用随机优化(stochastic optimization),即它们的解依赖于随机变量。

3. 元启发式的构建思路

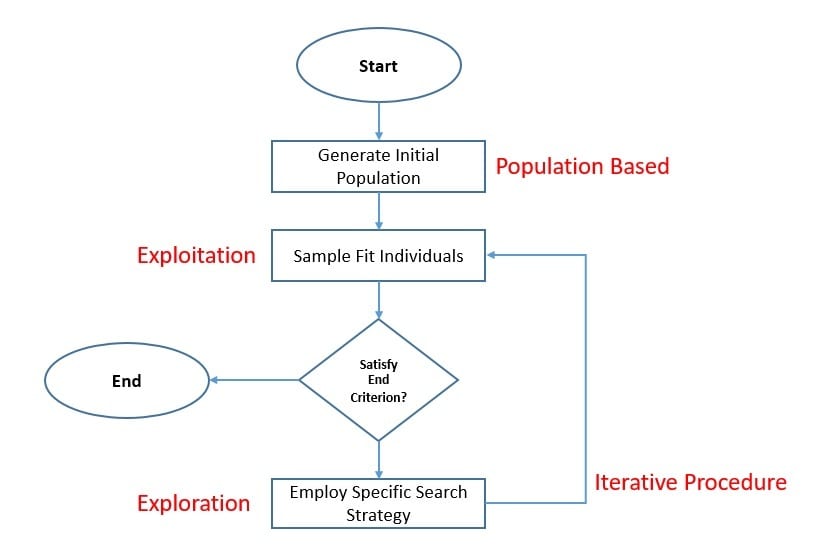

元启发式的目标是高效地探索搜索空间,以找到近似最优解。它们通常基于某种搜索策略,这种策略可以来源于自然界或人工系统。例如退火冶金过程、蚂蚁觅食行为等。

构建一个元启发式算法需要兼顾科学与工程目标:

- ✅ 科学目标:模拟某种自然现象背后的机制,如蚁群行为。

- ✅ 工程目标:设计可解决实际问题的系统。

虽然很难定义一个通用框架,但我们可以讨论一些关键特征:

- ✅ 探索(Exploration)与利用(Exploitation)的平衡:

- 探索:尽可能广泛地搜索可行区域,避免陷入局部最优。

- 利用:在有潜力的区域深入搜索,以找到更优解。

几乎所有元启发式算法都使用适应度函数(Fitness Function)来评估候选解,以便保留当前最优解用于利用。同时,通过引入随机性来增强探索能力,这是每个搜索策略独有的特性,因此很难用统一的公式表示。

这些元启发式算法可以用于求解多维实值函数,而无需依赖函数梯度。这一点非常重要,因为它意味着我们可以将这些算法用于非连续、噪声大或随时间变化的优化问题。这与使用梯度下降的算法(如线性回归)形成鲜明对比。

4. 自然启发式元启发算法的类型

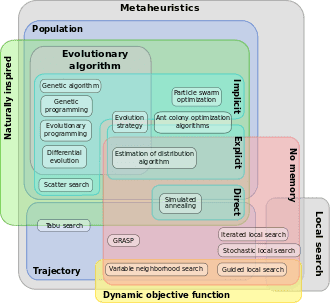

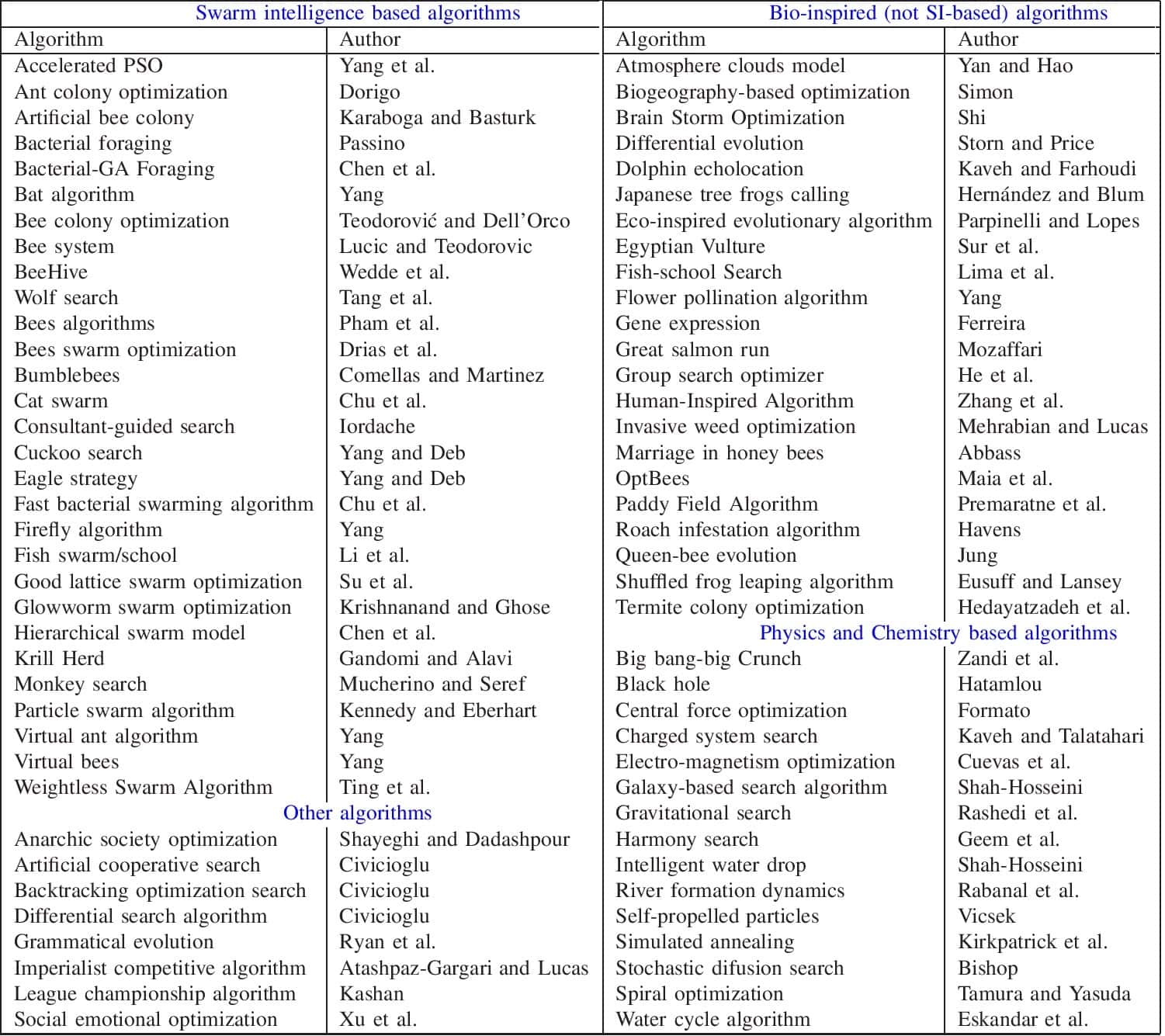

多年来,研究人员开发了大量新颖的元启发式技术。这些算法的搜索策略非常多样,导致了广泛的元启发式算法种类。因此,对其进行有意义的分类颇具挑战。

一种分类方式如下图所示:

本教程重点关注受自然启发的元启发式算法,即其搜索策略源于自然系统的元启发式算法。上图是一个欧拉图,展示了元启发式算法在局部 vs 全局搜索、单体 vs 群体搜索方面的分类。

进化计算(Evolutionary Computation, EC)是人工智能的一个子领域,包含一系列受生物进化启发的全局优化算法。我们可以根据其内在特性对自然启发式元启发式进行分类。不过,我们将重点关注一类称为进化计算(Evolutionary Computation, EC)的自然启发式算法。

虽然进化计算内部有复杂的分类,但我们将重点介绍两大类:进化算法(Evolutionary Algorithms, EA) 和 群体算法(Swarm Algorithms, SA)。它们都使用基于群体的候选解表示和迭代的随机探索过程。

4.1 进化算法

进化算法(EA)是一类受达尔文进化论启发的算法。该理论指出,物种成员之间存在随机变异,后代可以继承个体特征,而生存竞争将使具有有利特征的个体得以存活。

进化算法正是基于这一理论,在搜索空间中寻找近似最优解。每一代(generation)包括:

- ✅ 父代选择(Parent Selection)

- ✅ 重组(Crossover)

- ✅ 变异(Mutation)

- ✅ 子代选择(Survivor Selection)

其中,交叉和变异负责探索,而父代和子代选择负责利用。

4.2 群体算法

群体算法(SA)受社会性动物或昆虫群体行为的启发。一个群体由多个个体(如蜜蜂)组成,每个个体的行为非常简单、局部且随机。即使没有中心控制,个体之间的相互作用也能产生全局智能行为,称为群体智能(Swarm Intelligence, SI)。

这些算法模拟蚂蚁、蜜蜂等自然个体的集体行为。关键在于群体内部的信息共享机制,它直接影响每个个体的移动方向。通过控制群体内个体的信息共享,我们可以在搜索空间中实现探索与利用的平衡。

5. 常见的进化算法

自几十年前进化计算(EC)诞生以来,研究者对其投入了大量精力,形成了许多成熟的算法,如遗传算法(GA)、遗传编程(GP)、进化编程(EP)和差分进化(DE)等。下面我们介绍其中几种常见的进化算法。

5.1 遗传算法(Genetic Algorithm)

遗传算法(GA)是目前最古老且最流行的自然启发式元启发算法之一。它由 John Holland 于 1975 年提出,基于自然选择机制,核心思想是“适者生存”。

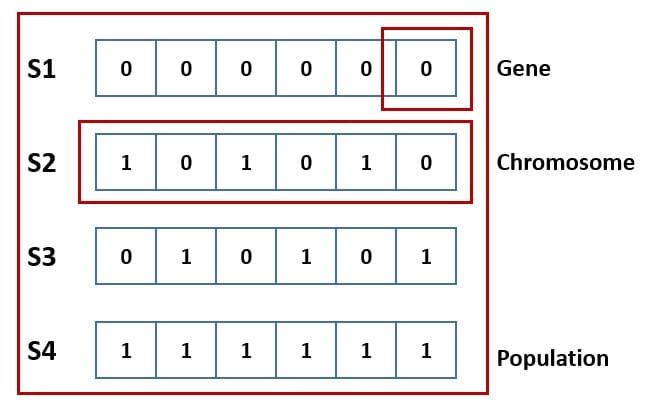

在 GA 中,问题的解被编码为染色体(Chromosome),由多个参数(称为基因)组成。这些基因组合成一个字符串表示一个完整的解:

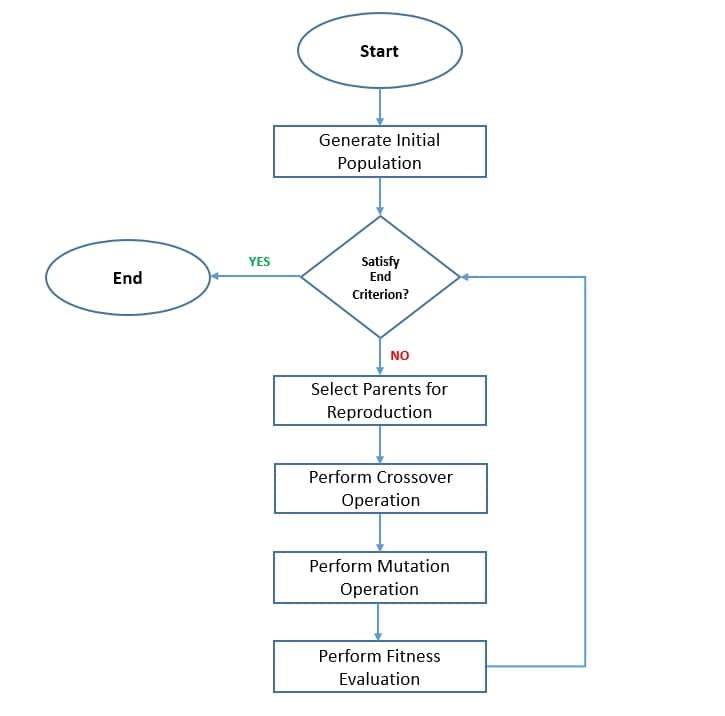

算法流程如下:

- 初始化种群(随机或启发式)

- 使用适应度函数评估个体并排序

- 淘汰低适应度个体

- 使用交叉和变异生成新个体

- 重复直到满足终止条件

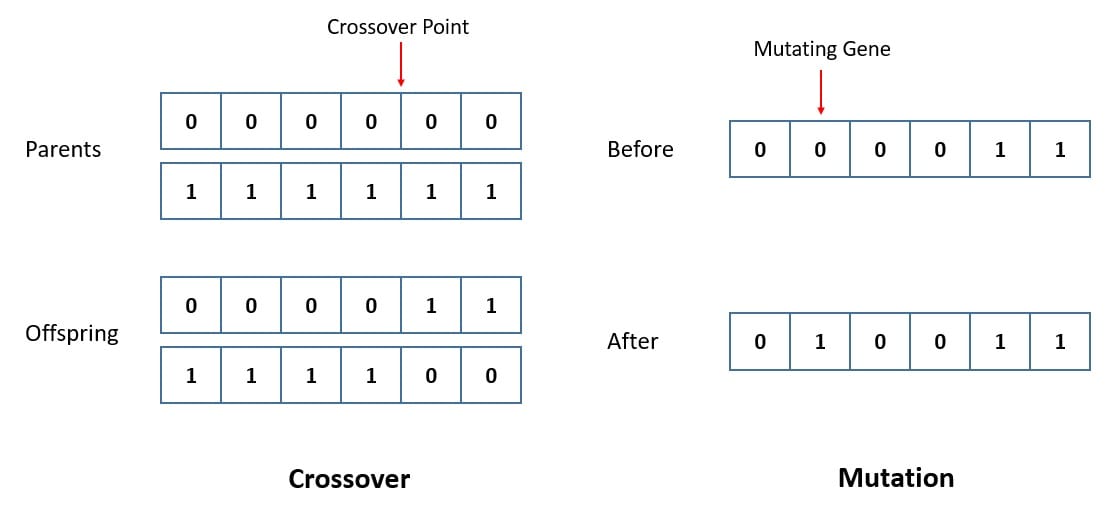

交叉(Crossover)和变异(Mutation)是遗传算法的核心操作:

- 交叉:从种群中随机选择两个染色体,交换部分基因生成新个体。

- 变异:随机改变某个染色体的基因值,以增加多样性。

算法循环进行,直到达到最大迭代次数或找到满意解。也可以引入精英保留策略(Elitism)防止最优解在交叉和变异中被破坏。

5.2 差分进化(Differential Evolution)

差分进化(DE)是另一种非常流行的进化算法,由 Rainer Storn 和 Kenneth Price 于 1997 年提出。它与遗传算法类似,但主要通过变异操作寻找更优解。

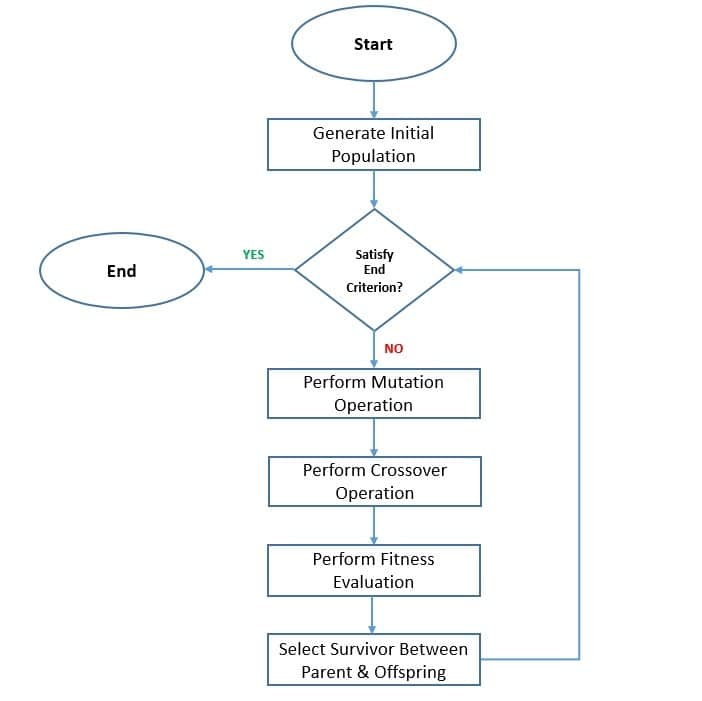

流程如下:

- 初始化种群

- 评估适应度

- 对每个个体执行变异、交叉和选择操作生成新个体

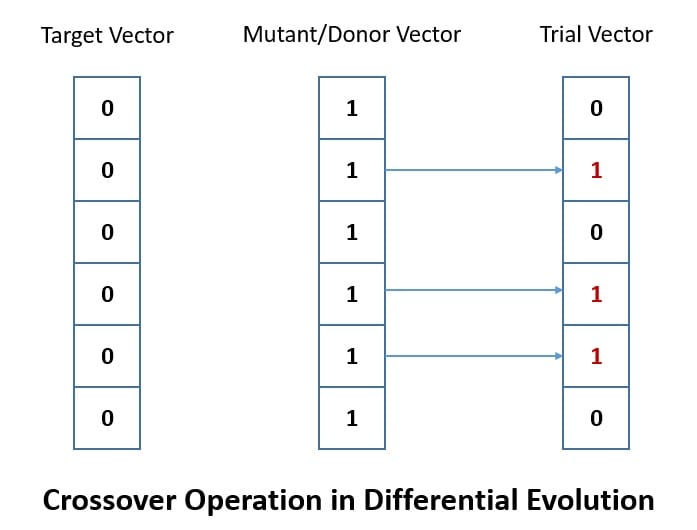

DE 中有三个参数向量用于生成新个体:

- 基向量(Base Vector)

- 差向量(Difference Vector)

在变异阶段,通过基向量和差向量生成一个突变向量(Donor Vector):

接着,在目标向量和突变向量之间进行交叉,生成试验向量(Trial Vector)。最终根据适应度函数选择保留哪一个。

与遗传算法不同,DE 中所有个体被选为父代的概率相同。只有当子代优于父代时才保留,否则丢弃,从而确保最优解的保留。

6. 常见的群体算法

群体算法是进化计算中相对较新的研究方向,也是当前非常活跃的研究领域。文献中不断涌现出新的元启发式算法,例如樽海鞘群算法(Salp Swarm Algorithm)、灰狼优化算法(Grey Wolf Optimization)等。本节我们将介绍两个最经典的群体算法:蚁群优化(ACO)和粒子群优化(PSO)。

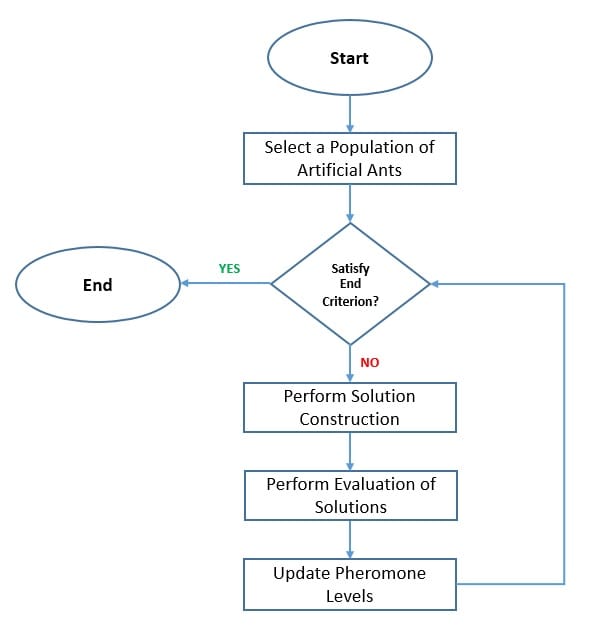

6.1 蚁群优化(Ant Colony Optimization)

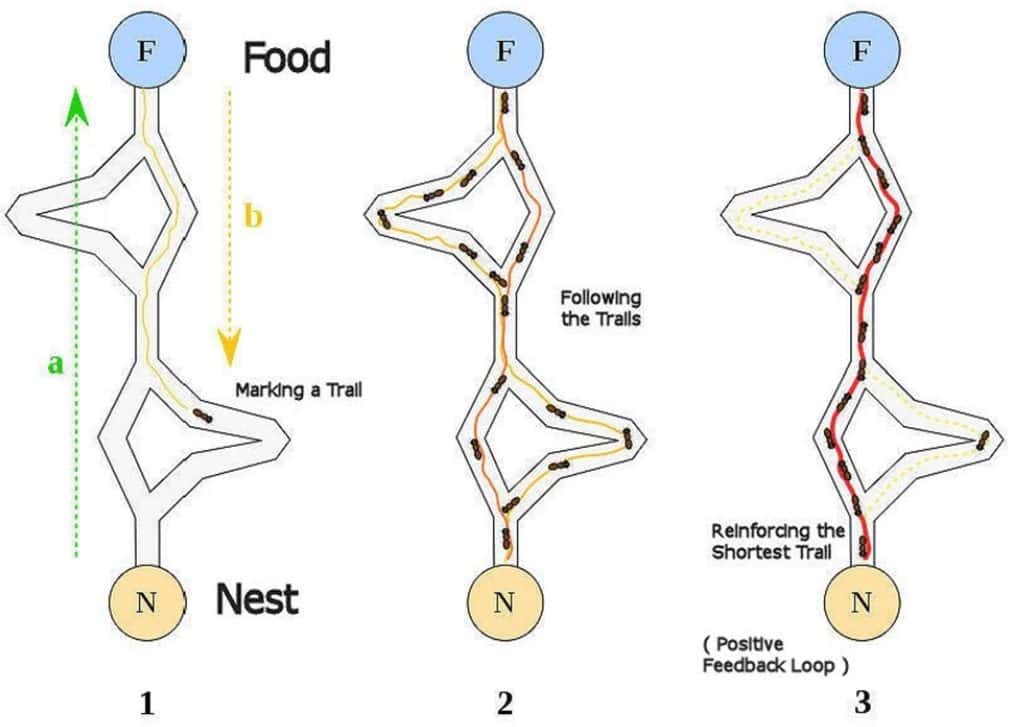

蚁群优化(ACO)是群体智能领域最早且研究最广泛的元启发式算法之一。由 Marco Dorigo 于 1992 年在其博士论文中提出,灵感来自蚂蚁的觅食行为。蚂蚁通过信息素(Pheromone)找到蚁巢与食物之间的最短路径。

蚂蚁在路径上留下信息素,其他蚂蚁倾向于跟随信息素浓度高的路径。随着时间推移,信息素会蒸发。较短路径上的信息素浓度更高,因此更容易被选择。

算法流程如下:

- 将优化问题转化为加权图上的最短路径问题

- 使用“蚂蚁”作为虚拟代理进行搜索

- 每只蚂蚁构建一个解(路径)

- 根据路径质量更新信息素强度

信息素通过沉积(Deposit)和蒸发(Evaporation)进行更新:

- ✅ 沉积:根据路径质量增加信息素

- ✅ 蒸发:信息素随时间减少

信息素机制在探索与利用之间取得平衡。

6.2 粒子群优化(Particle Swarm Optimization)

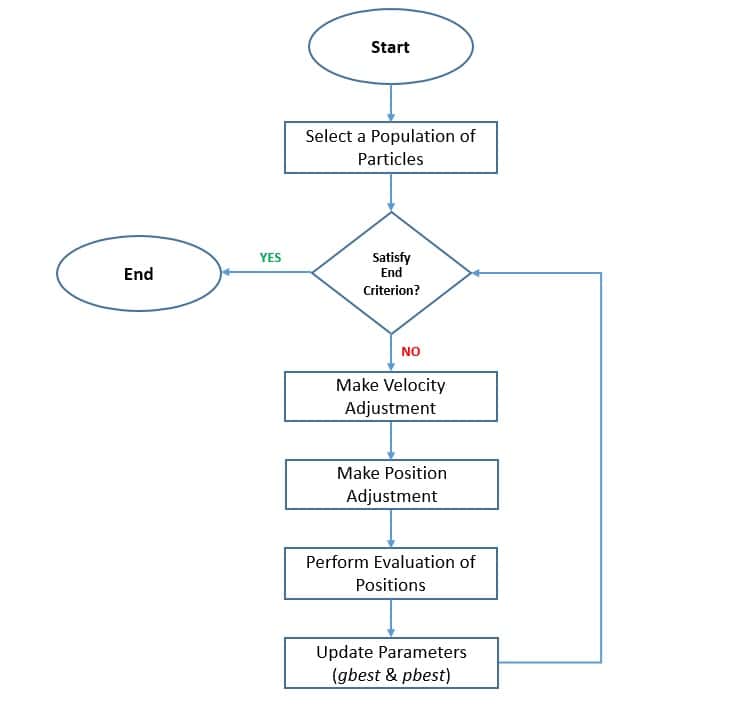

粒子群优化(PSO)是群体智能领域的另一热门算法,由 J. Kennedy 和 R. Eberhart 于 1995 年提出。灵感来自鸟群和鱼群的简单群体行为。

算法流程如下:

- 初始化粒子种群(即候选解)

- 根据粒子位置和速度规则在搜索空间中移动

- 每个粒子受自身历史最优(pbest)和群体历史最优(gbest)影响

- ✅ gbest 是引导粒子向最优区域收敛的关键

- ✅ pbest 维持粒子多样性,防止早熟收敛

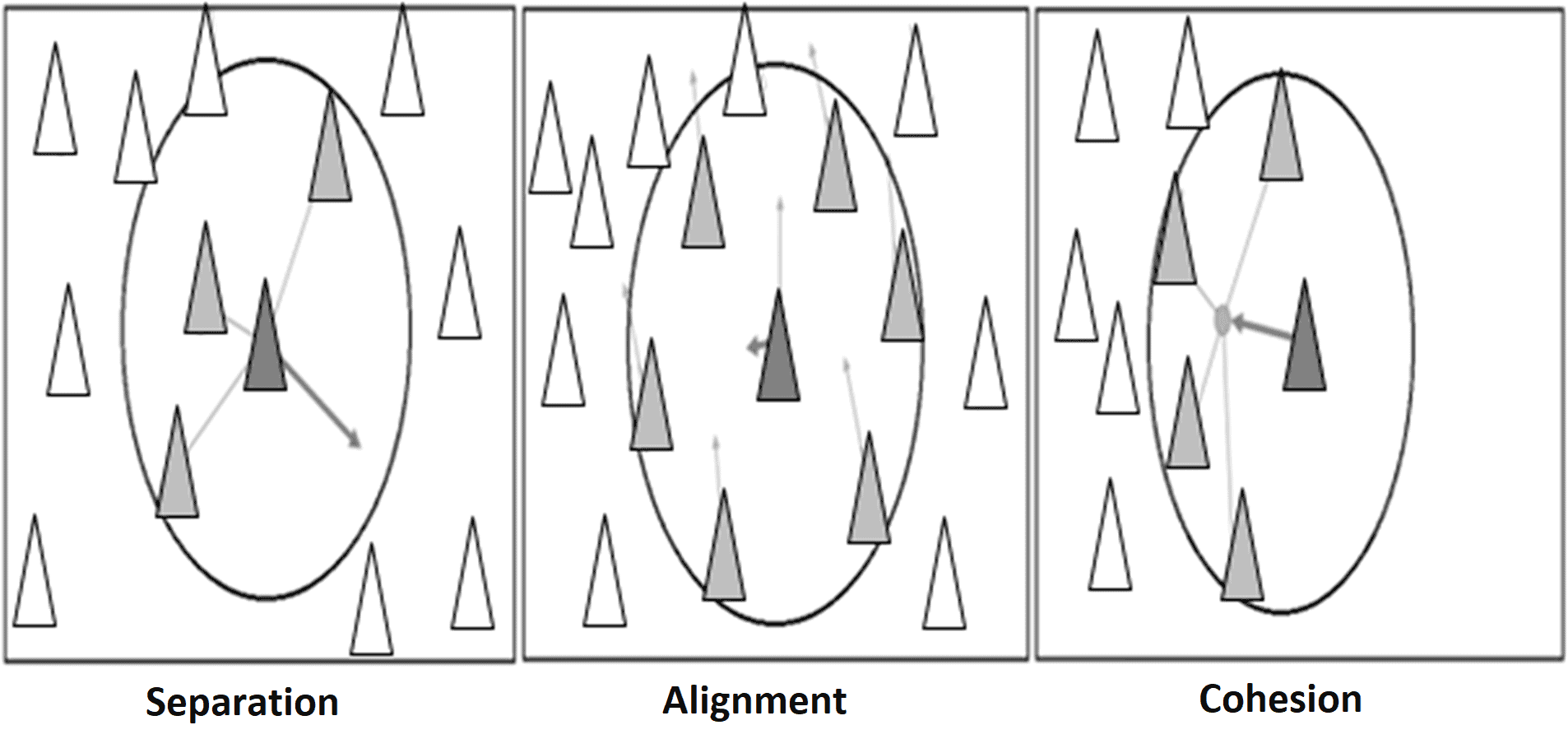

PSO 的直观理解可以通过以下行为描述:

- ✅ 分离(Separation):避开局部拥挤

- ✅ 对齐(Alignment):朝局部平均方向移动

- ✅ 凝聚(Cohesion):朝局部平均位置移动

这些行为帮助算法在探索与利用之间取得平衡。

7. 其他有趣的算法

正如我们前面所见,元启发式算法已有半个世纪的发展历史,但仍是活跃的研究领域。没有任何一种元启发式算法能解决所有优化问题,因此随着新问题的出现,研究者不断开发新的启发式算法。

我们前面讨论的主要是受生物启发的算法,但自然启发式元启发算法的范围远不止于此。它还可以包括来自化学、物理等领域的启发,例如引力算法、河流形成算法、电磁场算法、黑洞算法等。

虽然这一领域已有大量高质量研究,但多数研究仍停留在实验阶段。虽然文献中声称具有新颖性和实用性,但是否适用于实际工程问题仍需验证。我们应进行严谨评估,判断其价值。

尽管已有多种分类尝试,包括本教程中提到的分类,但我们应认识到它们的价值是有限的,不应过于拘泥。元启发式算法的灵感来源之间存在大量交叉,因此其分类必然复杂。

8. 实际应用

元启发式算法之所以受到广泛关注,是因为它们能有效解决现实中难以处理的优化问题。在工程和其他领域中,我们常常面对庞大且复杂的搜索空间,传统方法效率低下。

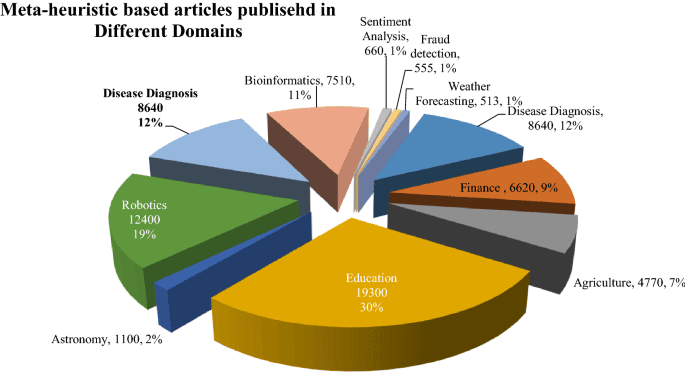

早期元启发式算法已成功应用于著名的组合优化问题,如旅行商问题。近年来,它们在教育、机器人、医学诊断、情感分析、金融、欺诈检测等领域也有广泛应用:

元启发式算法对优化问题的假设极少,因此适用范围广泛。但它们在不同问题上的表现差异较大,因此需要针对具体问题进行定制化改进。

这也催生了大量基于自然启发式算法的变体,远远超出本教程所能涵盖的范围。此外,大量研究致力于调整算法参数,使其更适合特定问题领域。

最后要指出的是,尽管我们对这些算法有了一定理解,但它们在本质上仍像黑箱一样工作,难以预测哪种算法在特定形式下对某个问题表现最好。随着新问题的不断出现和对性能要求的提升,我们必须持续投入研究。

9. 总结

本教程中,我们介绍了自然启发式元启发式算法的基本概念及其重要性。虽然这类算法种类繁多,但我们重点讨论了进化算法和群体算法中的几个经典算法。最后,我们还探讨了这些算法在实际中的应用。

自然启发式元启发式算法为我们提供了一种处理复杂优化问题的新思路。虽然它们不能保证找到最优解,但在计算资源有限的情况下,它们是目前最有效的解决方案之一。