1. 概述

在本文中,我们将探讨在机器学习任务中使用神经网络的主要优缺点。阅读完本文后,你将了解在哪些情况下使用神经网络是合理的,以及在哪些场景下应该避免使用它,而选择其他方法。

2. 神经网络简介

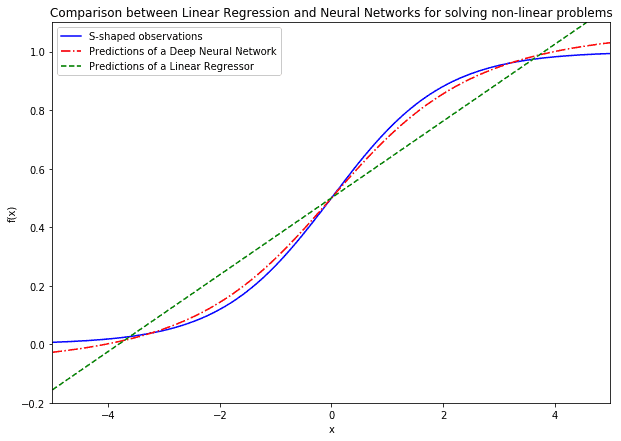

我们讨论的神经网络主要包括前馈单层网络和深度神经网络。这类网络最初是为了解决线性回归方法无法处理的问题而提出的。在感知机(perceptron)刚被提出时,线性回归模型已经可以提取变量间的线性关系,但面对非线性问题时就显得力不从心。

多层感知机(MLP)随后出现,成为解决非线性问题的关键方案。它通过节点之间的前向传播和非线性激活函数(如Sigmoid函数)实现非线性建模。

激活函数是神经网络的核心。使用非线性激活函数后,网络可以模拟复杂的非线性关系:

线性回归适用于线性问题,而神经网络更适合处理非线性问题。其优势在于:

✅ 神经网络可以在其他机器学习方法失败时,尝试解决未知结构的问题。

3. 通用近似定理及其局限性

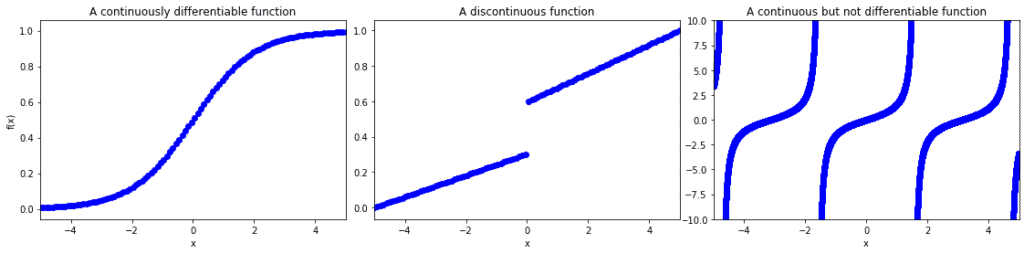

神经网络的另一个优势是其函数逼近能力。根据通用近似定理(Universal Approximation Theorem):

一个具有单个隐藏层且足够大的神经网络,可以逼近任意连续可导函数。

这意味着,只要问题可以用一个连续函数建模,就可以尝试使用神经网络来解决。

但需要注意的是,虽然理论上可以逼近任意函数,实际训练过程中可能无法找到最优解。比如:

- 权重初始化不当可能导致陷入局部最优

- 损失函数优化过程可能无法收敛

- 网络结构选择不当也可能影响逼近能力

⚠️ 神经网络对权重初始化非常敏感,这是其一大缺点。

4. 没有免费午餐定理(No Free Lunch Theorem)

该定理指出:

没有一种算法能在所有问题上都表现良好。

换句话说,某个神经网络架构可能在一个任务上表现优异,但在另一个任务上却完全无效。

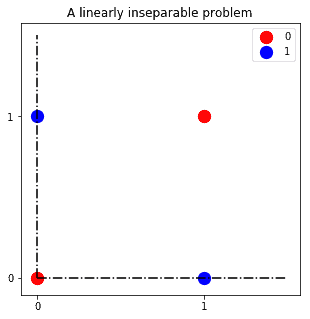

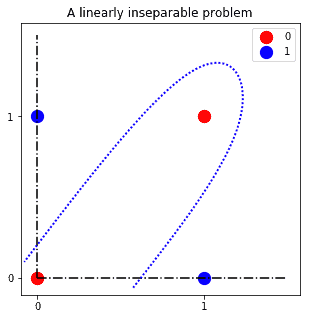

以XOR问题为例:

传统感知机无法解决该问题,但引入隐藏层的神经网络则可以学习出一个合适的分类超平面:

这说明:

✅ 神经网络擅长解决线性不可分问题

❌ 但对某些问题,其他模型可能更合适

5. 数据与计算资源需求

神经网络对数据和计算资源的需求远高于其他机器学习算法。例如著名的图像分类模型 AlexNet,在两个GPU上训练了整整六天才完成。

主要挑战包括:

- 非线性激活函数的梯度计算成本高

- 数据顺序影响训练结果,需多次训练以避免局部最优

- 网络参数矩阵增长速度快于线性

- 不同架构效果差异大,需反复试错

- 网络是“黑盒”系统,难以解释其内部逻辑

⚠️ 神经网络训练成本高,且不易解释。

6. 是否存在解析解?

6.1. 问题背景知识的重要性

在很多任务中,神经网络并非最优解。有些问题其实可以通过数学建模直接求解。

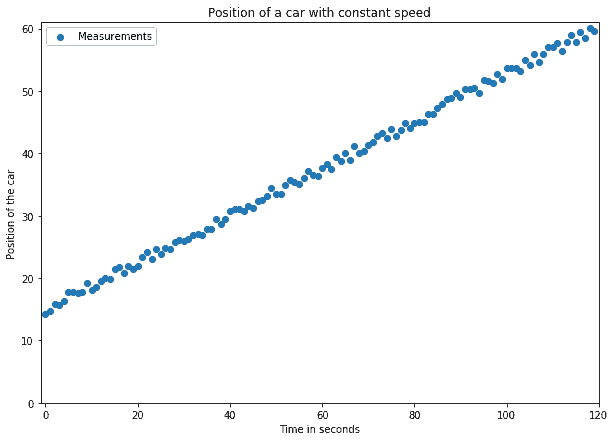

以汽车匀速运动为例:

假设我们测量了汽车在不同时间点的位置,试图用神经网络预测未来某一时刻的位置:

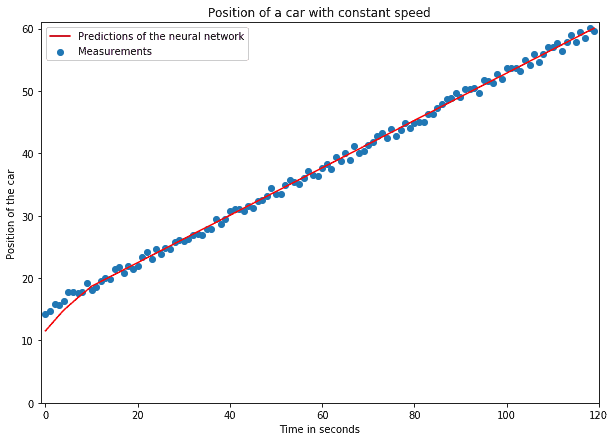

虽然模型预测准确,但其实这个问题可以通过物理公式直接求解:

$$ x_F = x_0 + v \cdot t_F $$

6.2. 能用解析解就别用神经网络

这种情况在实践中并不少见。我们应优先查找是否有解析解,而不是一上来就上深度学习模型。

✅ 优先查文献或自己推导解析解

❌ 不要一上来就盲目使用神经网络

7. 总结

神经网络的优点包括:

- 可以逼近任意连续可导函数(通用近似定理)

- 擅长解决线性不可分问题

- 能处理非线性复杂关系

但也存在明显缺点:

- 对权重初始化敏感

- 训练成本高

- 是黑盒模型,难以解释

- 并非所有问题都需要用神经网络

最后总结几点建议:

✅ 使用神经网络的前提:

- 问题没有已知解析解

- 数据充足且计算资源充足

- 问题结构复杂,难以用传统方法建模

❌ 避免使用神经网络的情况:

- 问题有已知解析解

- 数据或计算资源有限

- 需要可解释性强的模型