1. 概述

本文将讲解什么是回归器(Regressor),并通过示例说明在不同回归模型中如何解释回归器的作用。此外,我们还会介绍回归分析的基本概念及其应用场景。

2. 回归器(Regressor)

回归器是统计学中的一个术语,指的是在回归模型中用于预测响应变量(Response Variable)的变量。它也被称为:

- 自变量(Independent Variable)

- 解释变量(Explanatory Variable)

- 预测变量(Predictor Variable)

- 特征(Feature)

- 操控变量(Manipulated Variable)

这些术语在不同领域(如机器学习、统计学、生物学、计量经济学)中使用方式略有不同,但本质上都是指用于预测目标变量的输入变量。

3. 回归分析(Regression Analysis)

为了更好地理解回归器的作用,我们先来看一下回归分析。

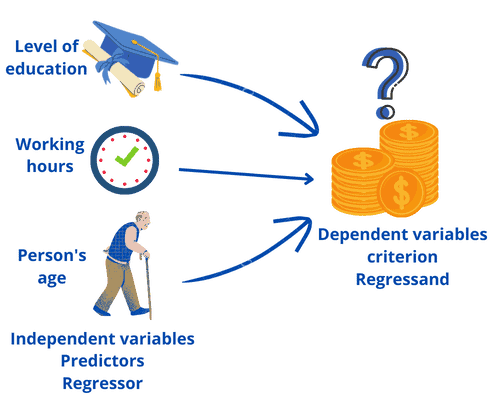

回归分析是一种统计方法,用于根据一个或多个变量来推断或预测另一个变量。例如,我们想研究哪些因素会影响一个人的工资水平:

在这个例子中,我们可以通过学历、每周工作时间、年龄等变量来预测工资水平。我们想要预测的目标变量称为:

- 因变量(Dependent Variable)

- 被解释变量(Regressand)

- 准则变量(Criterion)

而用于预测的变量则称为:

- 回归器(Regressor)

- 自变量(Independent Variable)

- 预测变量(Predictor)

回归分析通常有两个主要目标:

3.1. 变量影响的测量

用于评估一个或多个变量对另一个变量的影响程度:

- 示例 1:什么因素影响儿童的注意力集中能力

- 示例 2:父母的教育程度和居住地是否影响儿童未来的教育水平

3.2. 变量的预测

用于通过一个或多个变量来预测另一个变量的值:

- 示例 1:病人在医院的住院时长

- 示例 2:用户最有可能从电商网站购买哪种产品

4. 回归模型中的回归器

构建回归模型的核心在于理解回归器的变化如何引起响应变量(Regresand)的变化。

这类模型可以包含一个或多个回归器:

- 若模型中只有一个回归器,则称为简单线性回归(Simple Linear Regression)

- 若模型中有多个回归器,则称为多元线性回归(Multiple Linear Regression)

4.1. 单个回归器的线性回归

简单线性回归是一种基础的机器学习回归方法,其目标是通过一条直线来最小化数据点与该直线之间的误差,从而建立一个线性关系模型。

其数学表达式如下:

$$ Y_i = \beta_0 + \beta_1 X_i + \epsilon_i $$

其中:

- $i$:观测索引,$i = 1, ..., n$

- $Y_i$:响应变量(因变量)

- $X_i$:回归器(自变量)

- $\beta_0$:截距(Intercept)

- $\beta_1$:斜率(Slope)

- $\epsilon_i$:误差项(Error Term)

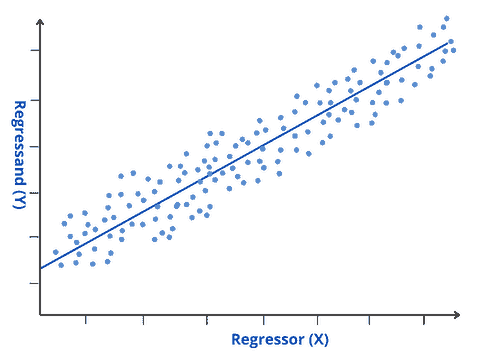

下图展示了回归器 $X$ 和响应变量 $Y$ 之间的线性关系拟合过程:

4.2. 示例 1:考试成绩与学习时间

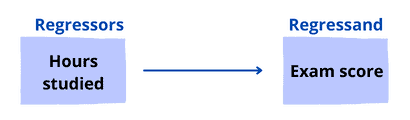

假设我们想研究学习时间对考试成绩的影响。我们收集数据并建立如下模型:

$$ \text{Exam Score} = 68.34 + 3.44 \times (\text{Hours Studied}) $$

模型结构如下图所示:

模型中只有一个回归器:学习时间(Hours Studied)。其系数表示:每多学习 1 小时,考试成绩平均提高 3.44 分。

✅ 小结:简单线性回归适用于一个回归器对响应变量影响的建模,直观且易于解释。

4.3. 多个回归器的回归模型

当模型中包含多个回归器时,我们通常使用多元线性回归。例如,多项式回归就是一种多元线性回归的形式。

多元线性回归的一般形式如下:

$$ Y_i = \beta_0 + \beta_1 X_{1i} + \beta_2 X_{2i} + \cdots + \beta_k X_{ki} + \epsilon_i \quad \text{其中 } i = 1, 2, ..., n $$

其中:

- $Y_i$:第 $i$ 个观测的响应变量

- $X_{1i}, X_{2i}, ..., X_{ki}$:第 $i$ 个观测的 $k$ 个回归器

- $\beta_0$:截距

- $\beta_j$:第 $j$ 个回归器的系数,表示在控制其他变量不变的情况下,该变量每变化一个单位,响应变量的期望变化

- $\epsilon_i$:误差项

使用多个回归器可以提高模型的拟合精度,更全面地捕捉变量之间的关系。

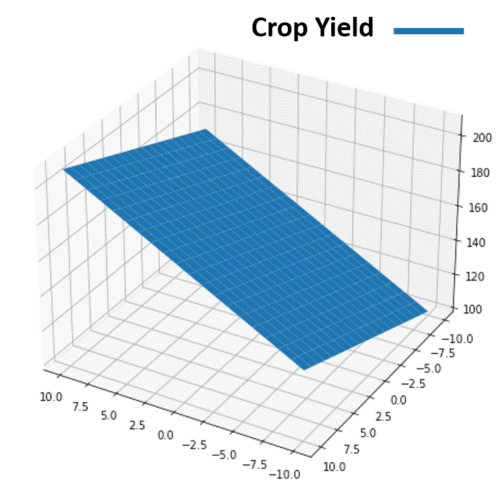

4.4. 示例 2:农作物产量预测

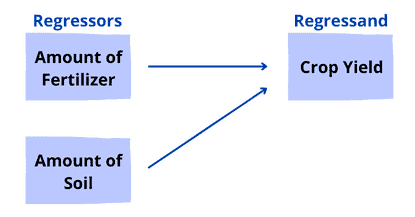

我们想研究哪些因素会影响农作物的总产量(单位:磅)。我们收集数据并建立如下模型:

$$ \text{Crop Yield} = 154.34 + 3.56 \times (\text{Pounds of Fertilizer}) + 1.89 \times (\text{Pounds of Soil}) $$

模型结构如下图所示:

对两个回归器的解释如下:

- 肥料(Fertilizer):在土壤使用量不变的前提下,每增加 1 磅肥料,农作物产量平均增加 3.56 磅

- 土壤(Soil):在肥料使用量不变的前提下,每增加 1 磅土壤,农作物产量平均增加 1.89 磅

下图展示了多元线性回归中回归器(肥料、土壤)与响应变量(产量)之间的关系:

✅ 小结:多元线性回归能更全面地捕捉多个变量对目标变量的影响,适用于复杂场景建模。

5. 应用场景

在机器学习中,回归模型被广泛用于理解多个回归器与响应变量之间的关系。模型可以识别出哪些因素对目标变量具有显著影响。

以下是回归模型的一些典型应用场景:

- ✅ 预测连续型输出,如销售额、股价、房价等

- ✅ 分析数据集,建立回归器与响应变量之间的关系

- ✅ 预测用户行为趋势,如电商网站的购买倾向

- ✅ 预测零售业未来的销售表现,以便合理配置资源

- ✅ 构建时间序列可视化模型

⚠️ 踩坑提醒:在使用多元回归时要注意多重共线性(Multicollinearity)问题,避免回归器之间高度相关导致模型不稳定。

6. 总结

本文介绍了回归器(Regressor)和响应变量(Regressand)的基本概念,并通过示例说明了它们在简单线性回归和多元线性回归中的作用。我们也简要回顾了回归分析的两个主要目标:

- 测量变量之间的因果关系

- 基于已有变量预测目标变量

回归模型是机器学习和统计分析中的基础工具,掌握其原理和应用对于构建有效的预测模型至关重要。