1. 概述

在本文中,我们将深入探讨深度学习中的潜在空间(Latent Space)。首先会给出潜在空间的定义,并解释它在深度学习中的重要性,接着通过几个典型应用场景来帮助理解其实际意义。

潜在空间是深度学习模型中一个非常核心的概念,它不仅影响模型的表达能力,也决定了模型如何理解数据之间的内在关系。对于有经验的开发者来说,理解潜在空间有助于更好地设计模型结构、优化训练过程以及提升模型性能。

2. 潜在空间的定义

潜在空间是一个抽象的多维空间,用于编码外部观察事件的有意义内部表示。简单来说,就是模型对输入数据的一种“压缩理解”。在这个空间中,相似的样本会被映射到相近的位置。

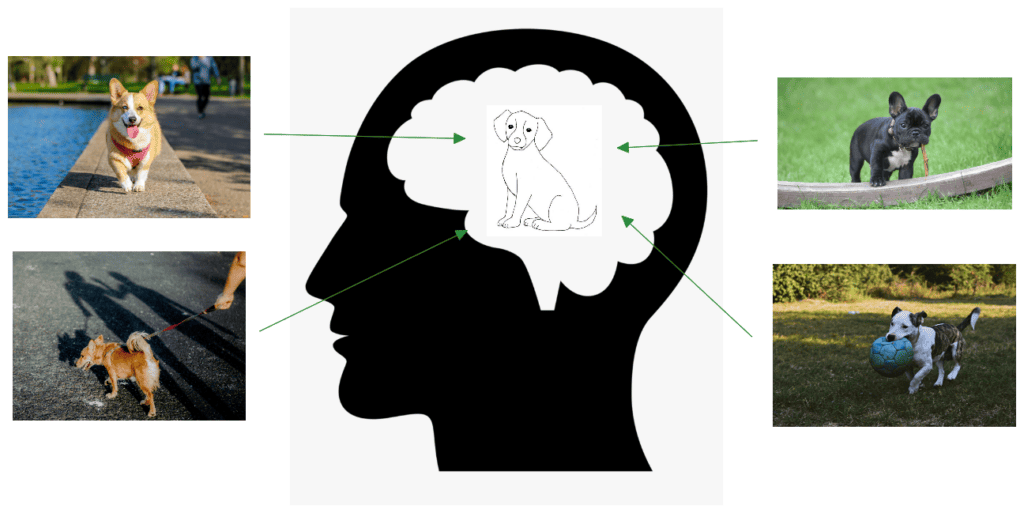

我们可以类比人类的认知方式来理解这个概念。我们并不需要记住所有关于“狗”的视觉细节,而是通过大脑中的一个抽象表示来识别狗。如下图所示:

类似地,深度学习模型通过潜在空间来“理解”世界,将高维输入数据压缩为低维向量,从而捕捉其关键特征。

3. 在深度学习中的重要性

深度学习之所以强大,是因为它能够将原始数据(如图像像素、文本字符)转化为有意义的内部表示。这些表示通常就是潜在空间中的向量。

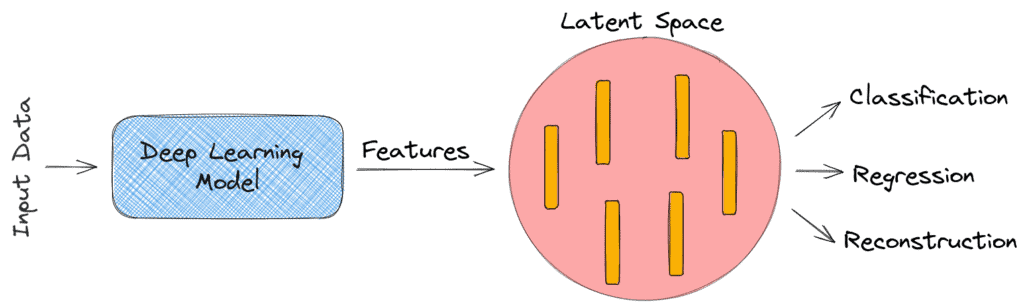

下图展示了一个典型的流程:模型将原始数据映射到潜在空间中,然后基于这些特征完成分类、回归或重建等任务。

为什么需要潜在空间?

一句话:数据压缩。当输入数据维度极高时(比如一张 512x512x3 的 RGB 图像有 786,432 个像素),直接从中学习是不现实的。

✅ 通过神经网络将高维输入编码为低维潜在向量,可以:

- 降低计算复杂度

- 提高模型泛化能力

- 更好地捕捉数据的语义信息

4. 典型应用场景

以下是一些常见的深度学习场景中潜在空间的应用,它们都依赖于良好的潜在表示来实现高性能。

4.1. 图像特征空间

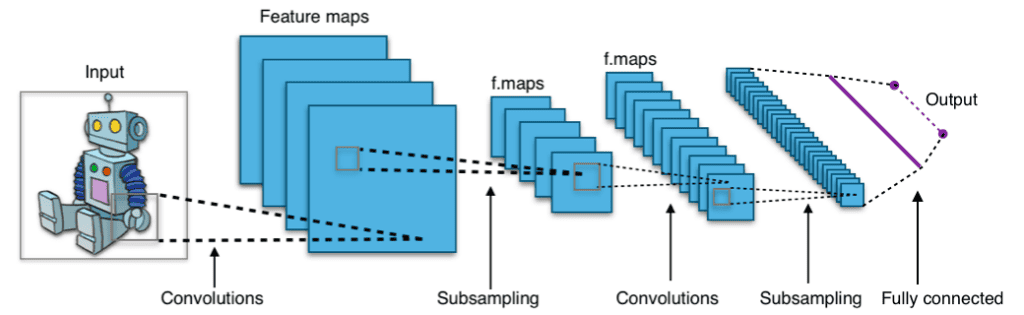

在图像分类任务中,CNN 会将图像从像素空间逐步抽象为高维语义特征。最后一层输出的特征向量就构成了图像在潜在空间中的表示。

下图展示了 CNN 的结构:

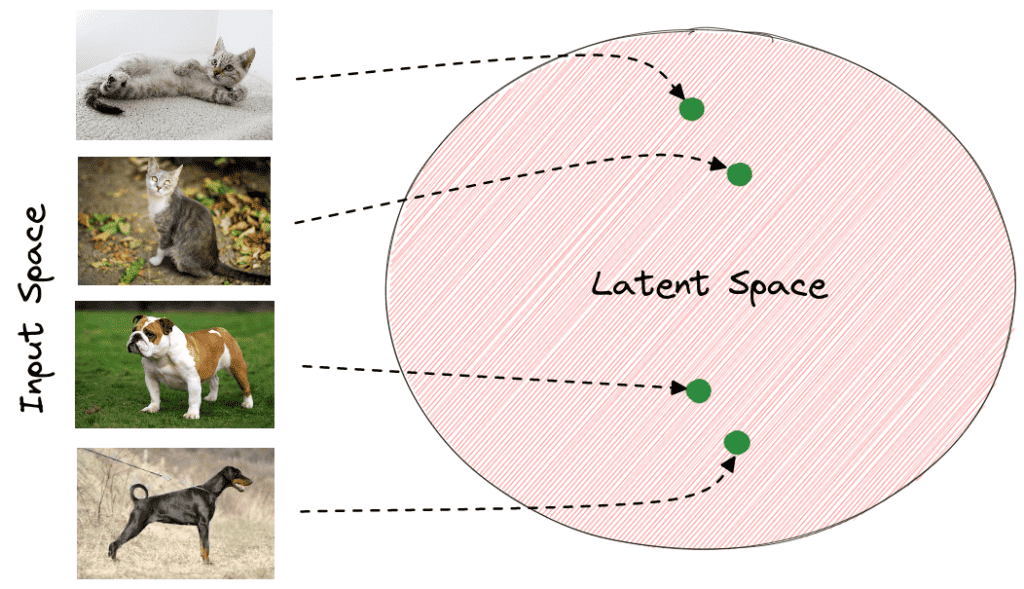

训练完成后,相同类别的图像在潜在空间中距离较近。例如,下图展示了动物分类模型的潜在空间分布:

这种分布使得分类器更容易做出判断,而不是直接在像素空间中比对。

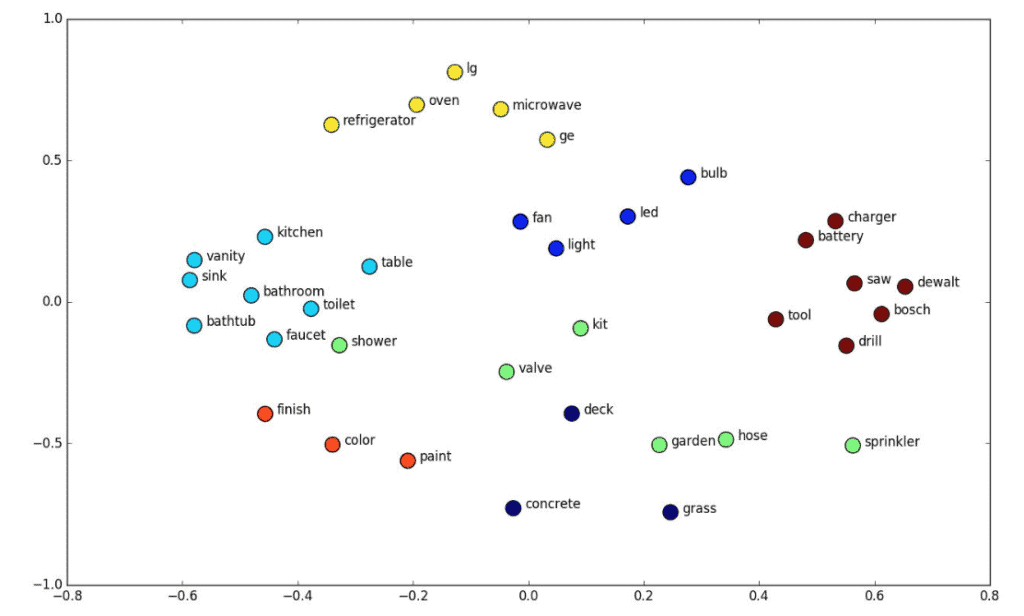

4.2. 词嵌入空间(Word Embedding Space)

在自然语言处理中,词嵌入(Word Embedding)是词语的向量表示,它将词语映射到一个潜在空间中,使得语义相近的词在空间中距离较近。

常见的词嵌入方法包括 Word2Vec 和 GloVe。如下图所示:

比如“toilet”和“bathroom”这两个词在潜在空间中位置相近,说明它们语义相似。

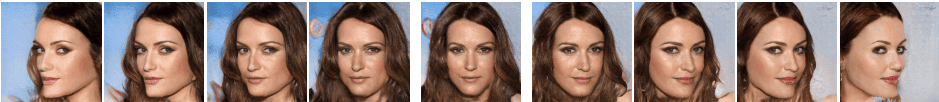

4.3. GAN 中的潜在空间

生成对抗网络(GAN)是一种生成模型,它的输入是一个随机向量 z,输出是一张图像 **G(z)**。这个输入向量 z 就是潜在空间中的一个点。

GAN 的目标是学习真实数据的分布,并生成类似的数据。潜在空间在这个过程中起到了“控制参数”的作用。

例如,我们可以通过在潜在空间中进行插值来控制生成图像的属性。如下图所示,通过调整潜在向量,可以改变人脸的姿势:

这说明潜在空间中不同的维度可能对应不同的语义属性(如姿势、表情等)。

5. 总结

潜在空间是深度学习模型中非常关键的一个组成部分。它帮助模型从高维输入中提取出低维、语义丰富的特征表示,是实现分类、生成、理解等任务的基础。

✅ 本文通过图像特征空间、词嵌入空间和 GAN 的潜在空间三个典型场景,展示了潜在空间在深度学习中的广泛应用。

对于开发者而言,深入理解潜在空间不仅有助于模型设计,还能在调参、调试、可视化等环节提供重要帮助。在实际项目中,合理设计潜在空间的结构、维度、训练方式,往往能显著提升模型效果。