1. 概述

负载均衡器(Load Balancer)是一种用于将网络流量分发到多个服务器上的设备或软件。它的核心作用是防止某一台服务器因请求过多而过载,从而导致响应延迟或服务不可用。通过合理分配流量,负载均衡器可以显著提升应用的性能和可用性,避免系统瓶颈,改善用户体验。

在本文中,我们将通过一个实际场景,来理解负载均衡器的工作原理。

2. 负载均衡器的工作原理

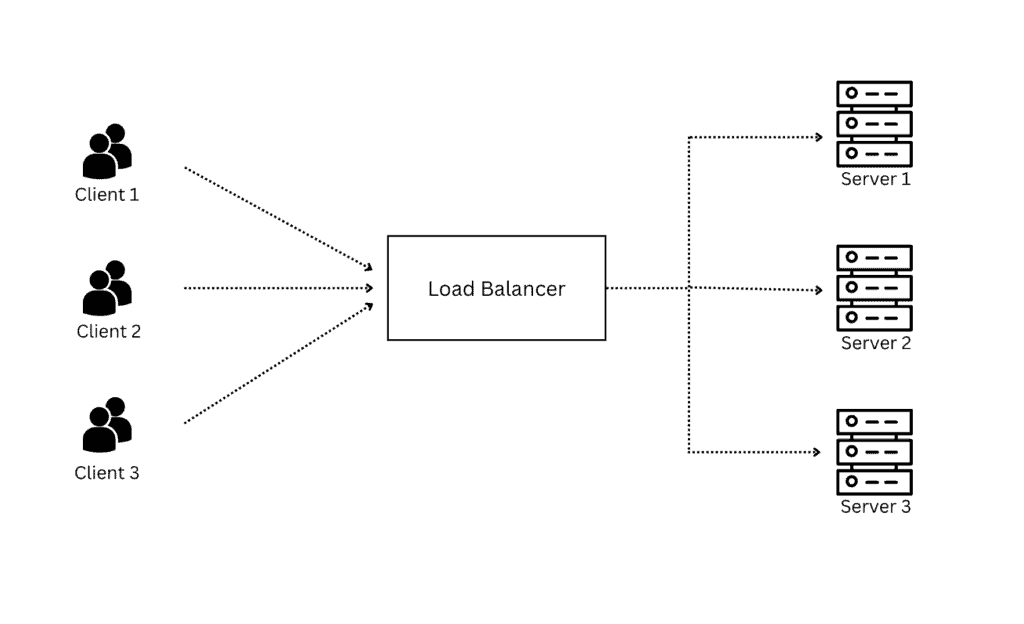

我们通过一个实际的场景来理解负载均衡器是如何处理大量请求的。例如,一个高流量的网站,为了应对不断涌入的访问请求,通常会部署多个 Web 服务器。为了合理地将这些请求分发到不同的服务器上,就需要引入负载均衡器。

负载均衡器就像一个“交通警察”,它位于多个 Web 服务器的前端,负责将请求路由到合适的服务器。 当客户端(如浏览器)发起请求时,请求首先到达负载均衡器。然后,负载均衡器根据某种算法决定将请求转发给哪台服务器。该算法会综合考虑服务器当前的负载、容量以及请求类型等因素。

选定目标服务器后,负载均衡器将请求转发给该服务器,服务器处理完成后将响应返回给负载均衡器,再由负载均衡器将响应返回给客户端。整个过程中,服务器对客户端是不可见的,负载均衡器是唯一对外暴露的接口,从而保护了后端基础设施:

通过这种方式,负载均衡器不仅实现了流量的合理分配,还带来了更好的扩展性、安全性和高可用性。

2.1. 路由算法

负载均衡器使用路由算法来决定将请求转发给哪台服务器。 最常见的两种算法是:

✅ 轮询(Round Robin)

负载均衡器按顺序依次将请求分发给各台服务器。假设我们有三台服务器,负载均衡器会依次将第1个请求发给服务器A,第2个发给B,第3个发给C,然后再回到A,以此类推。这种方式能保证每台服务器接收到的请求数大致均衡。如果某台服务器宕机,负载均衡器会跳过它,不再发送请求。

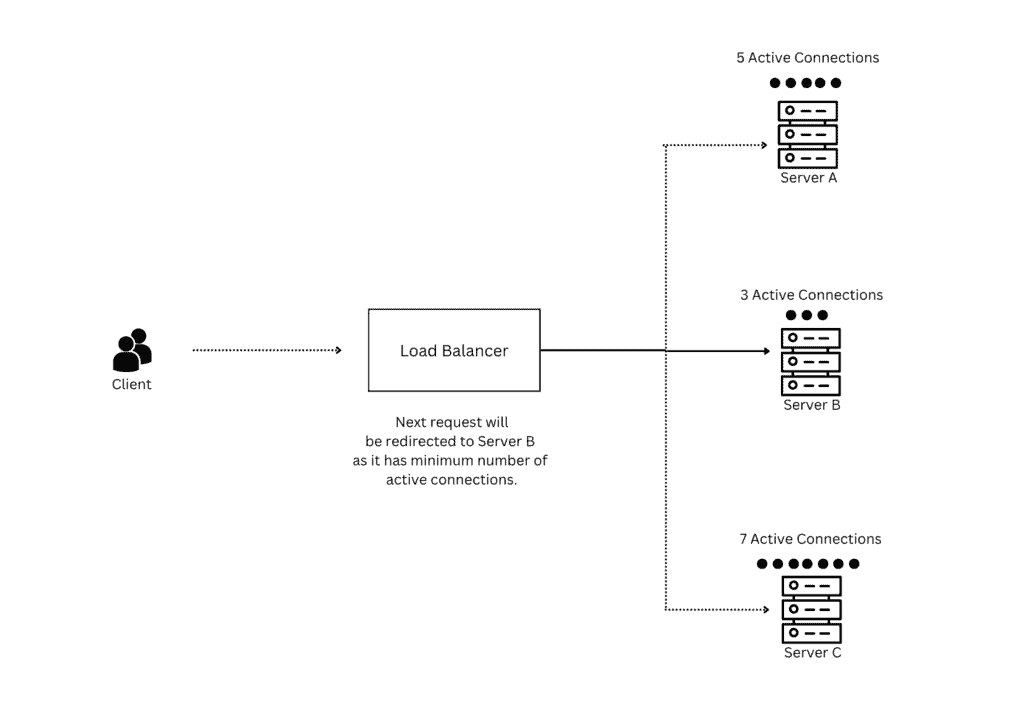

✅ 最少连接(Least Connections)

负载均衡器会跟踪每台服务器当前的连接数,并将新请求发给当前连接数最少的服务器。例如,假设三台服务器A、B、C当前的连接数分别为 10、3、7,那么新请求会被分配给服务器B:

这种方式更适合处理长连接或请求处理时间差异较大的场景。

3. 负载均衡器的类型

负载均衡器可以根据其工作层级或技术实现进行分类:

3.1 按照 OSI 层级分类

✅ 第4层负载均衡器(Layer 4)

工作在传输层(Transport Layer),主要根据源IP、目标IP和端口号来分发流量。适用于无状态服务,如 UDP、TCP 类型的应用。也被称为网络负载均衡器(Network Load Balancer)。

✅ 第7层负载均衡器(Layer 7)

工作在应用层(Application Layer),能够根据请求内容(如 HTTP 路径、Host 头等)进行更精细的路由控制。支持高级特性如 SSL 终止、基于内容的路由等,适合有状态或需要内容感知的应用。

3.2 按照技术实现分类

- 硬件负载均衡器:基于专用硬件设备(如 F5),性能高但成本昂贵。

- 软件负载均衡器:基于软件实现,如 Nginx、HAProxy,灵活且成本低。

- 云负载均衡器:由云厂商提供,如 AWS ELB、阿里云 SLB,便于集成和管理。

3.3 按照作用范围分类

- 区域负载均衡器(Regional LB):用于在单个数据中心或区域内部分发流量。

- 全局负载均衡器(Global LB):用于跨地域分发流量,实现全球访问优化。

4. 优缺点分析

| 优点 | 缺点 |

|---|---|

| ✅ 提升系统性能和可用性,避免单点过载 | ❌ 增加系统复杂度,维护成本上升 |

| ✅ 提高可扩展性,轻松应对流量增长 | ⚠️ 若设计不当,负载均衡器本身可能成为单点故障 |

| ✅ 提供 SSL 终止、内容路由等安全增强功能 | ❌ 增加部署和硬件/软件成本 |

5. 小结

在本文中,我们深入探讨了负载均衡器的工作机制,并介绍了常见的路由算法(轮询和最少连接)。负载均衡器作为现代分布式系统中不可或缺的一环,其作用不仅限于流量分发,还包括安全、扩展、高可用等多个方面。

合理使用负载均衡器,能显著提升系统的稳定性和性能。但也要注意避免其成为新的单点故障点,建议在高可用架构中对负载均衡器本身也进行冗余设计。